8. ウェブアーカイブの長期保存

長期保存とは

書物であれデジタルコンテンツであれ、アーカイブにおいては、そこに記録された内容を百年単位、千年単位の長期間にわたって利用できる状態で保存しなければなりません。そうした対策や試みは「長期保存」と呼ばれます。

デジタルコンテンツの長期保存にあたっては、考慮しなければならない特有の要点があります。それは、「ビット列の保存(Bit-stream preservation)」と「論理的な保存(Logical preservation)」です。「ビット列の保存」とは0と1からなる文字列を欠損なく完全に保存することで、「論理的な保存」とは0と1からなる文字列の意味を人が読み取り理解できるように再現することです。

ビット列の保存

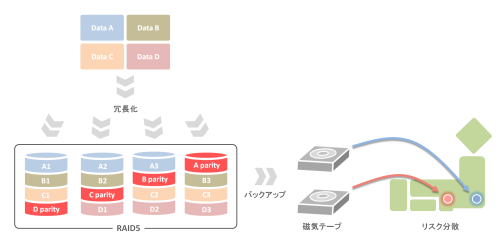

ビット列の保存はデジタルコンテンツの長期保存における最も基本的な対策で、冗長化とバックアップがその主な手段です。

冗長化

RAID(Redundant Arrays of Inexpensive Disks)などの技術を用いてデータを冗長化して保存することで、ハードディスクの故障によるデータの消失に備えることができます。

RAIDとは、複数のハードディスクを組み合わせて一つの仮想的なハードディスクとして使用し、ディスク故障時のデータ復旧を可能にする技術です。複数ディスクにデータを分散して記録(striping)、複数ディスクに同じ内容を記録(mirroring)、それらの組み合わせ、誤り訂正符号データ(parity)の使用などのヴァリエーションにより、いくつかのRAIDレベルがあります。

バックアップ

ハードディスクのデータを磁気テープなどの記録媒体に定期的にバックアップを取って複数世代を残します。さらに保存場所を分けてリスク分散(Disaster Recovery)を図ることも重要です。データを格納した記録媒体は物理的に安定した環境で保存し、記録媒体の劣化に対しては媒体変換などの対策が必要です。

論理的な保存

ビット列が完全に保存されていたとしても、人がその内容を理解できなくては意味がありません。論理的な保存の有力な方法がマイグレーション(Migration)とエミュレーション(Emulation)です。

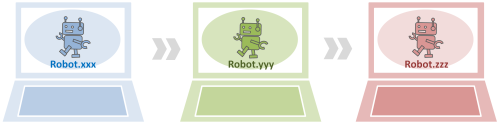

マイグレーション

ハードウェアやソフトウェアの環境の変化によりファイルが技術的に読めなくなってしまう前に、フォーマットを変換したり別の記録媒体へ移行したりする方法で、最も広く行われている対策です。

例えば、旧式のワープロソフトで作成したファイルを最新のワープロソフトのデータ形式にフォーマット変換をしたり、再生機器の変化にともないフロッピーディスクから光ディスクへと媒体を変えてデータを移行したりします。

ただし、環境が変化するごとにマイグレーションを繰り返す必要があるため、ウェブアーカイブのように大量なデータ群のマイグレーションには膨大なコストがかかります。また、マイグレーションを繰り返すことで起こりうるデータ改変や作業ミスによるデータ消失などの危険性もはらんでいます。

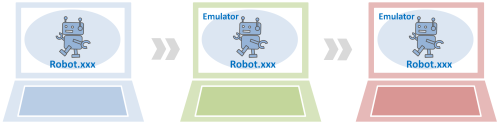

エミュレーション

エミュレータ(Emulator)と呼ばれるソフトウェアを使って、旧式化したファイルやソフトウェアの再生環境を新しいハードウェア・ソフトウェアの環境下で模擬的に再現することです。

例えば、Windows3.1でしか動作しないソフトウェアでも、エミュレータを使って最新のOS環境上でWindows3.1の環境を再現することで利用できるようになります。また、市場から消えてしまった専用ゲーム機でのみプレイできたゲームソフトも、エミュレータを使えばパソコン上でプレイすることができます。

オリジナルのファイルに変更を加えないためデータ改変などの危険性が少ないのが利点ですが、旧ファイルの再生環境を完璧に再現するのが難しいケースもあり、近似の再現に留まるエミュレータもあります。エミュレータの開発にはコストがかかりますが、マイグレーションのコストと比べて低く抑えられるため、今後、より洗練されたエミュレーション技術の確立が期待されます。あわせて長期的な保存に耐えうる信頼性の高い記録媒体が開発されれば、より有用な手段になると考えられています。

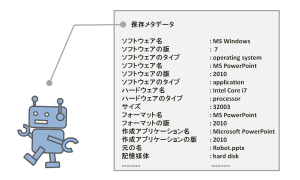

保存メタデータ

マイグレーションやエミュレーションを効果的に管理・実施するためには、データをアーカイブする時点で再生機器や再生環境、作成アプリケーション、ファイルフォーマットのヴァージョンなどを記録した保存メタデータを作成しておくことが求められます。保存メタデータに記録された情報と最新の技術動向を照らし合わせることで、ファイルの旧式化を適時に把握してマイグレーションを行ったり、エミュレーションの環境を適切に用意したりすることができます。

ウェブアーカイブの長期保存

以上、デジタルコンテンツの長期保存の技術についてみてきましたが、それではウェブアーカイブの長期保存はどこまで進んでいるのでしょうか?

ウェブアーカイブのデータはファイルの数量や種類が膨大なため、マイグレーションやエミュレーションを包括的に行うのは容易ではありません。それらをどのように施していくのがよいのか、使用するソフトウェアはなにが最良なのか、より効果的な別の方策はないのかなどについて、いくつかの調査や試行が行われていますが、未だ確実な方策は定まっていません。結果、多くのウェブアーカイブにおいては本格的な長期保存の対策がなされていないのが現状です。

世界中でウェブアーカイブが行われるようになって既に十数年が経過しますが、果たして古い時期のウェブサイトは今でも問題なく閲覧できるのでしょうか?例えば、WARPで保存している最も古い2000年9月のウェブサイト(下図)を見る限り、少なくともhtmlファイルや画像ファイルについては現在でも読み取ることができます。

一見すると問題ないように思えますが、ウェブサイトのなかには多種多様なフォーマットのファイルが含まれているため、なかには既に旧式化して読めなくなっているファイルがある可能性もあります。時間の経過とともにそのようなファイルは確実に増えていくでしょう。また、そもそも将来にわたってウェブ技術そのものが現在と同じであり続ける保障はどこにもありません。

このようにウェブアーカイブの長期保存は不安定な状況におかれていると言えるのです。ウェブ情報の多くは他の媒体には記録されていないため、長期保存に失敗した場合のインパクトは極めて大きいでしょう。そうした危機感のもと、IIPCを始めとする関係機関により長期保存の検討や研究開発が進められています。

ウェブアーカイブはウェブサイトを集めて保存すれば終わりではありません。長期間にわたって人が理解できるように保存し続けるためには、絶え間ない取り組みが欠かせないのです。

(最終更新日:2014/2/6)